2025年3月31日

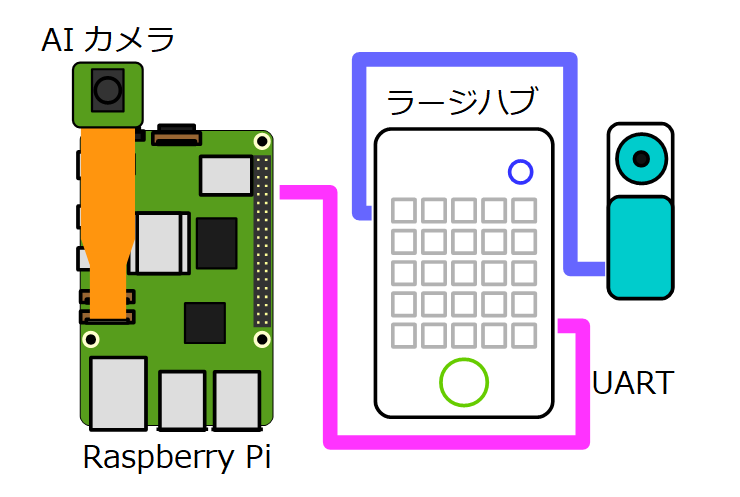

025-1.SPIKEプライム+ラズパイ+AIカメラ ロボットチャレンジ-第1回「AIカメラを準備する」

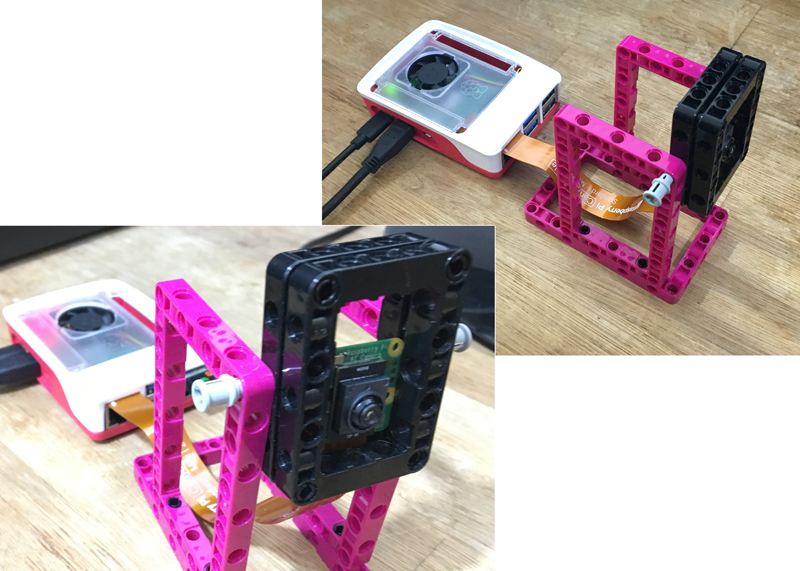

この記事では「レゴ エデュケーションSPIKEプライム(以下、SPIKE)」とRaspberry Pi(以下、ラズパイ)とAIカメラを組み合わせたロボットを作る方法について紹介します。(文/松原拓也)

◆ 材料をそろえる

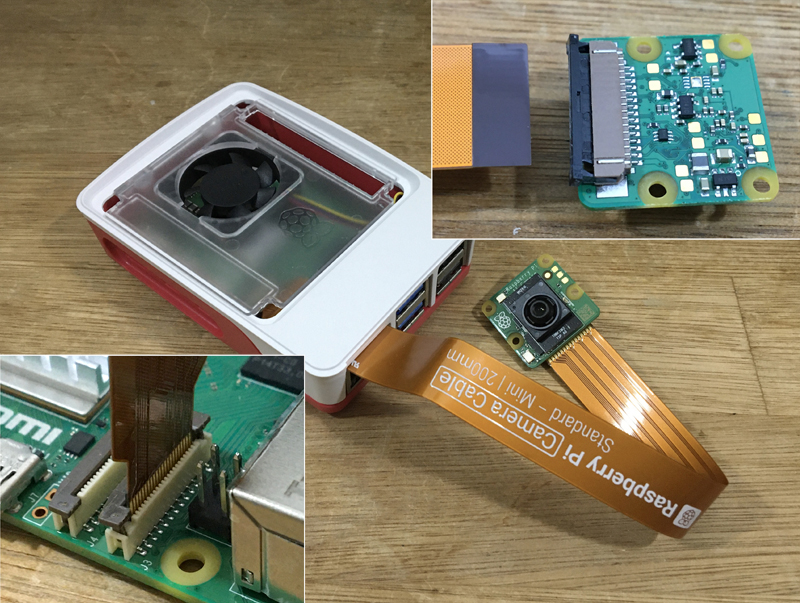

AIカメラは公式の「Raspberry Pi AI Camera」を使います。

このカメラはソニー製のインテリジェントビジョンセンサ「IMX500」を搭載しています。通常のカメラとは違って、カメラの内部でAIの機能をハードウェア的に処理することができます(AIアクセラレータ)。

このため、ラズパイ側の処理の負担を抑えることができます。実売価格は12,760~14,740円です。詳細については次のページに書かれています。

https://www.raspberrypi.com/products/ai-camera/ </

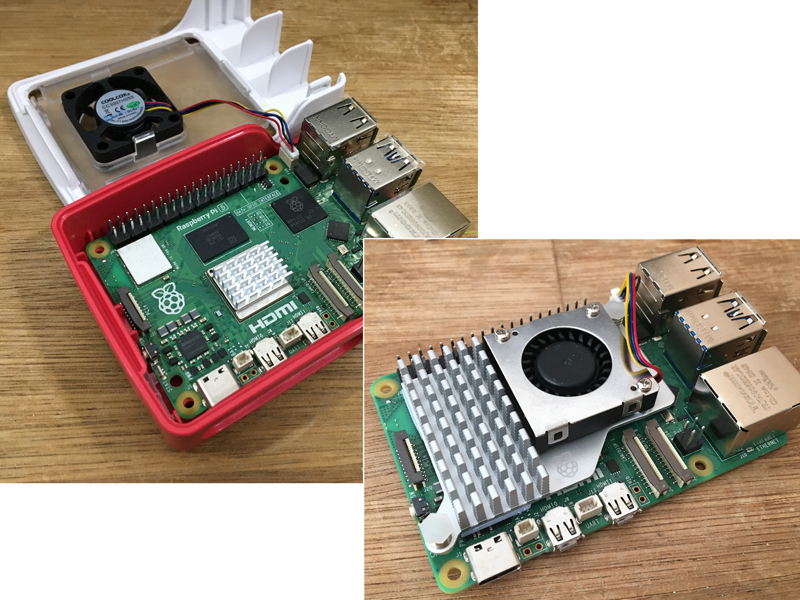

ラズパイは数多くの種類がありますが、今回はラズパイ5(4GB版) を使うことにします。

ラズパイ5は動作中、チップが激しく発熱します。その熱を下げないと、ラズパイは性能を十分に発揮することができません。そこで、冷却用のクーラー が必要です。公式のクーラーは「Raspberry Pi 5用公式ケース(に付属するクーラー)」と「Raspberry Pi 5用公式アクティブクーラー」の2種類があります。両方を組み合わせるという方法もあります。

公式ケースの場合はSoCにヒートシンクを粘着テープで貼り付けます。一度貼り付けてしまうと、取り外すのが大変です。アクティブクーラーの場合は複数のチップをヒートシンクで覆って冷やします。アクティブクーラーは基板にピンを挿し込む構造なので、取り外すことを推奨していないとのことです。

この記事では公式ケースを使うことにします。

◆ ソフトを入手する

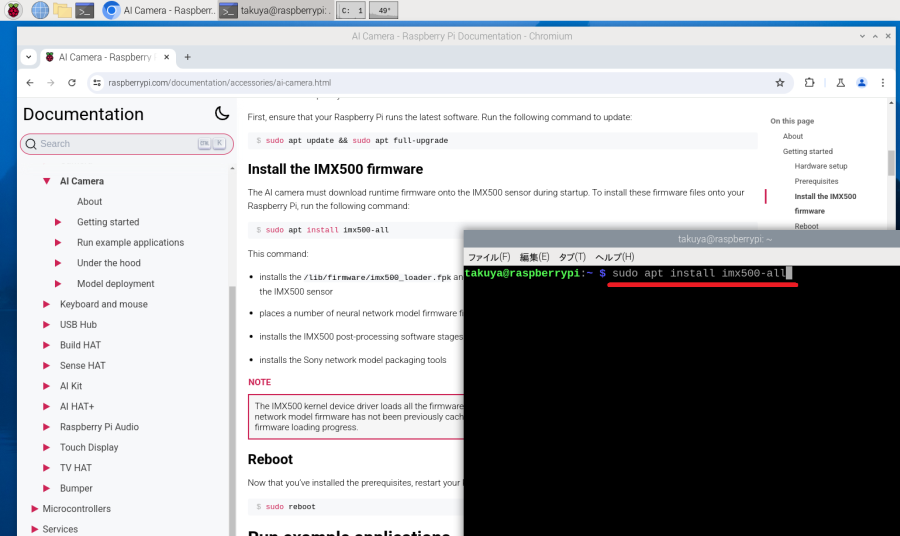

次のページの「Getting started」の内容の通りに、IMX500のファームウェアをインストールします。

https://www.raspberrypi.com/documentation/accessories/ai-camera.html

「LXTerminal」を起動して、「sudo apt update」「sudo apt full-upgrade」「sudo apt install imx500-all」のコマンドを入力します。実行後、ラズパイを再起動します。

これでファームウェアのインストールは完了です。

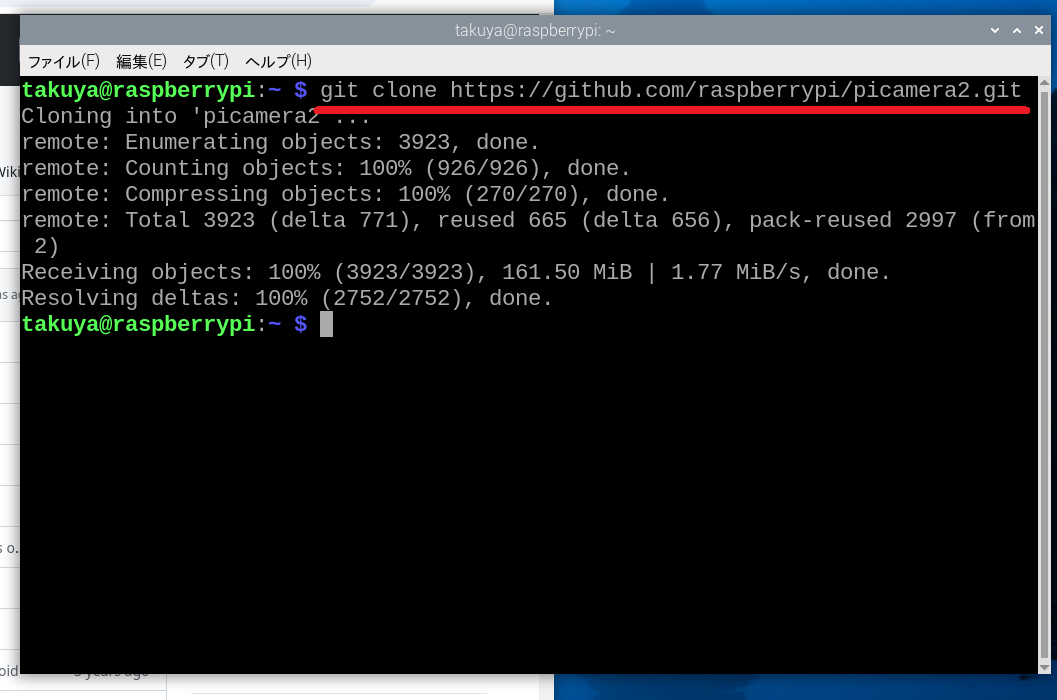

「picamera2」というライブラリの関連ファイルをGitから入手します。

https://github.com/raspberrypi/picamera2/

LXTerminalを起動して、「git clone https://github.com/raspberrypi/picamera2.git」と入力します。

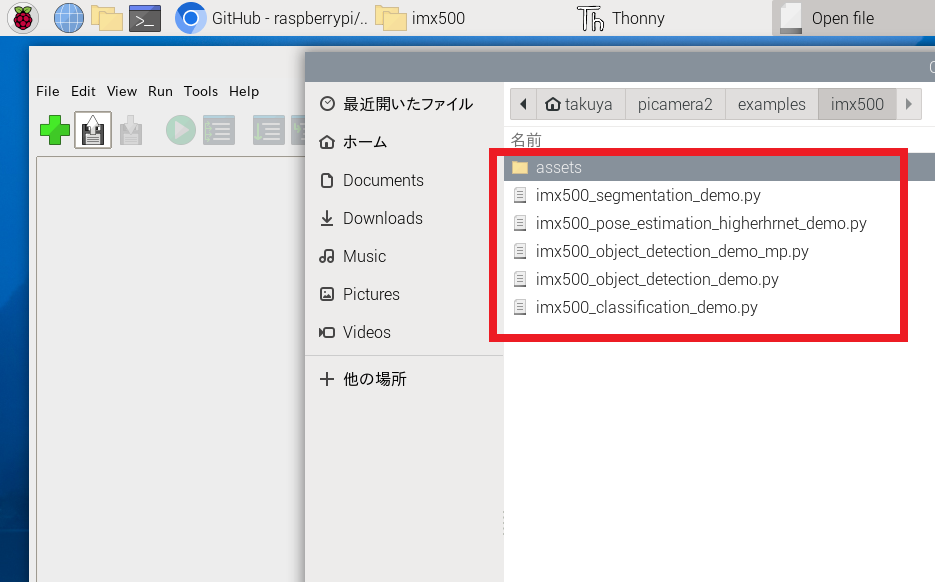

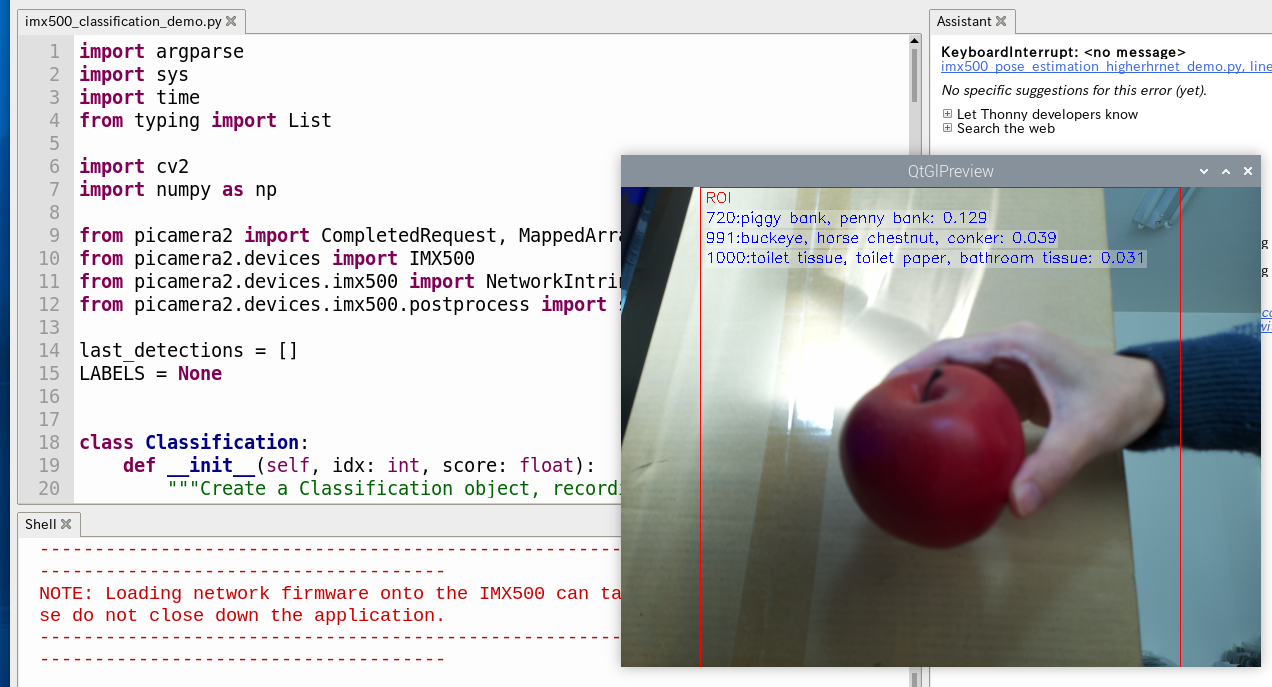

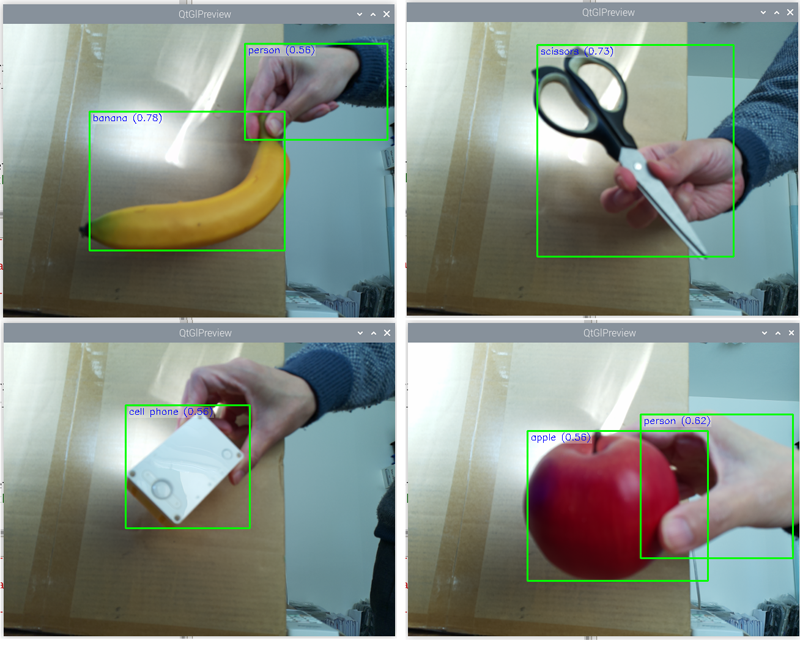

「imx500_classification_demo.py」を実行中の画面です。 このプログラムでは分類(Classification)という処理を行います。この例では「リンゴ」を撮影していますが、「piggy bank(ブタの貯金箱)」「buckeye,horse chestnut,conker(トチノキという植物)」「toilet tisssue,toilet paper,bathroom tissue(トイレットペーパー)」という複数の結果を表示しています。いずれも不正解です。名前の右側にある数値は信頼値(confidence values)です。

学習データは「imx500_network_mobilenet_v2.rpk」というファイルを使用しています。拡張子の「rpk」はIMX500独自のフォーマットのようです。

認識可能な物体については「assets/imagenet_labels.txt」というテキストファイルに書かれています。

「golden retriever」「mantis, mantid」「gar, garfish, garpike, billfish, Lepisosteus osseus」「croquet ball」「maillot, tank suit」「radio telescope, radio reflector」「tile roof」「volcano」などで、なんと1000種類の物体が登録されています。

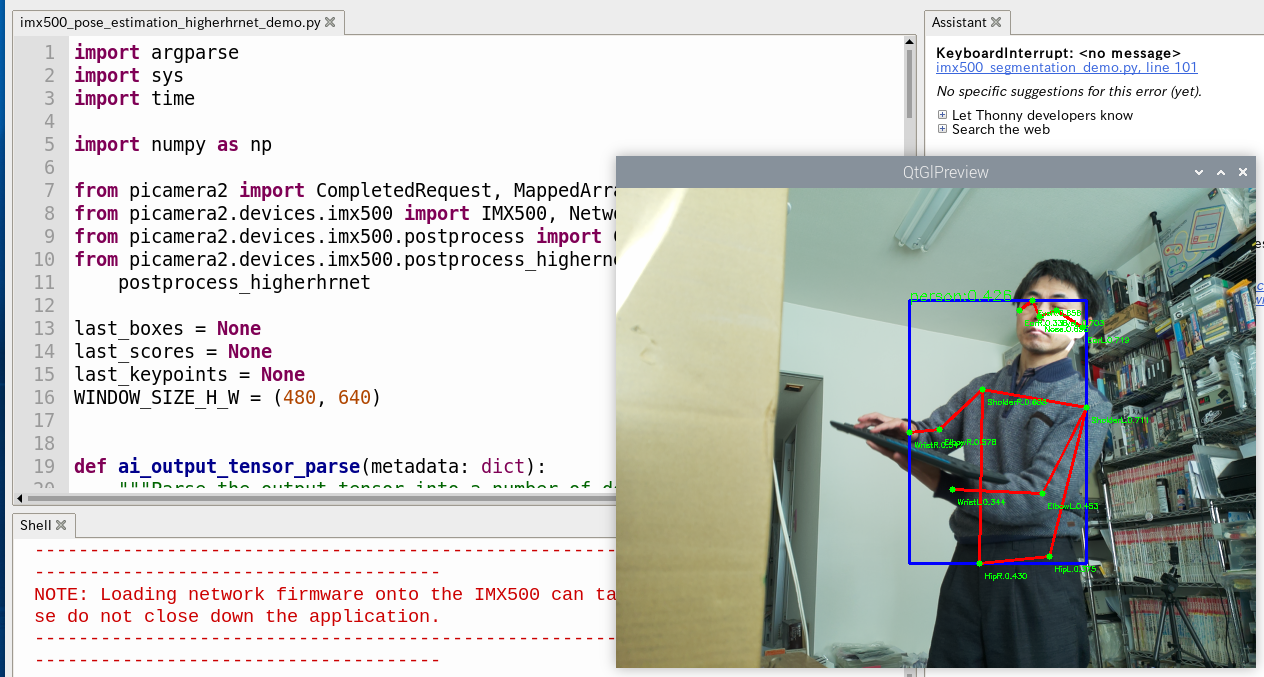

◆ 物体を認識する

今回はAIカメラを導入方法だけを紹介しました。どうやってロボットとしてまとめていくかは次回以降に考えます。

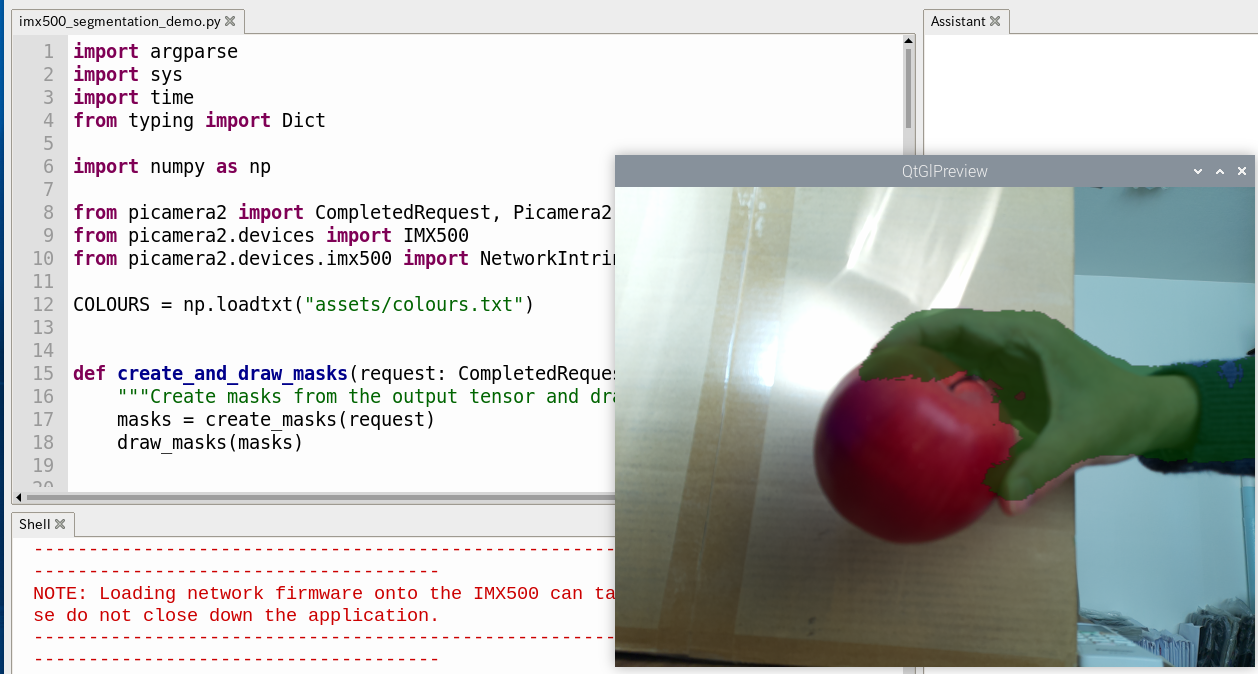

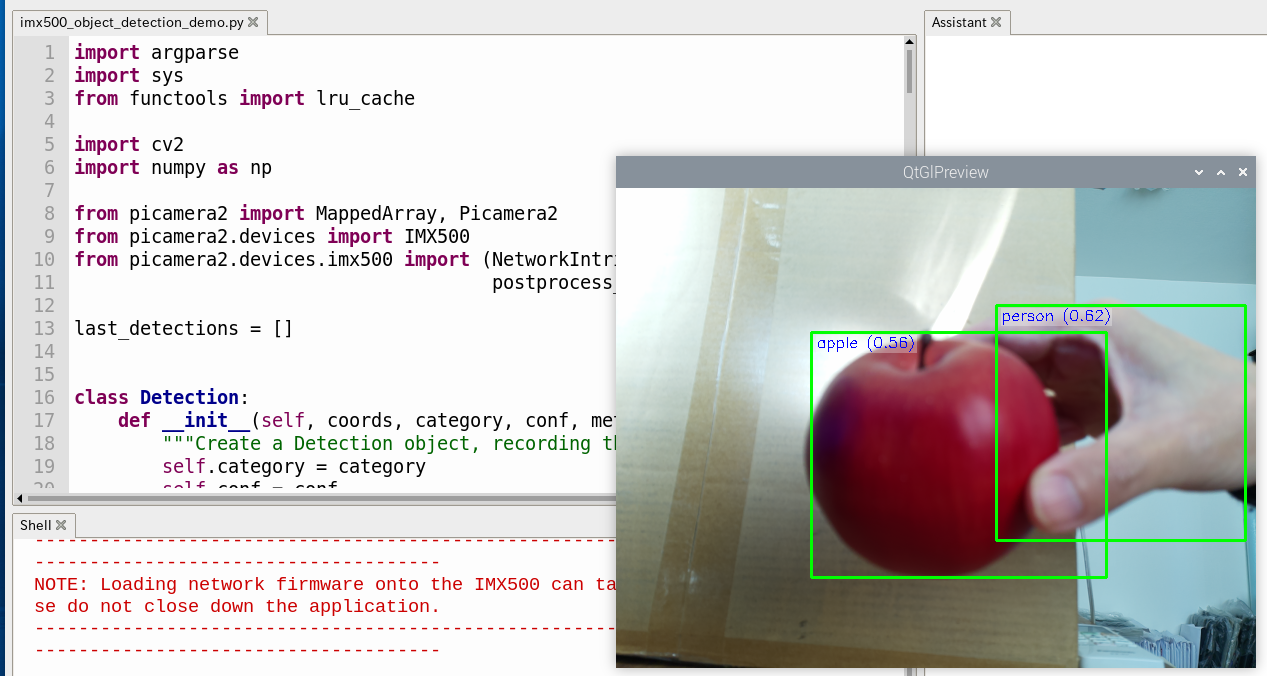

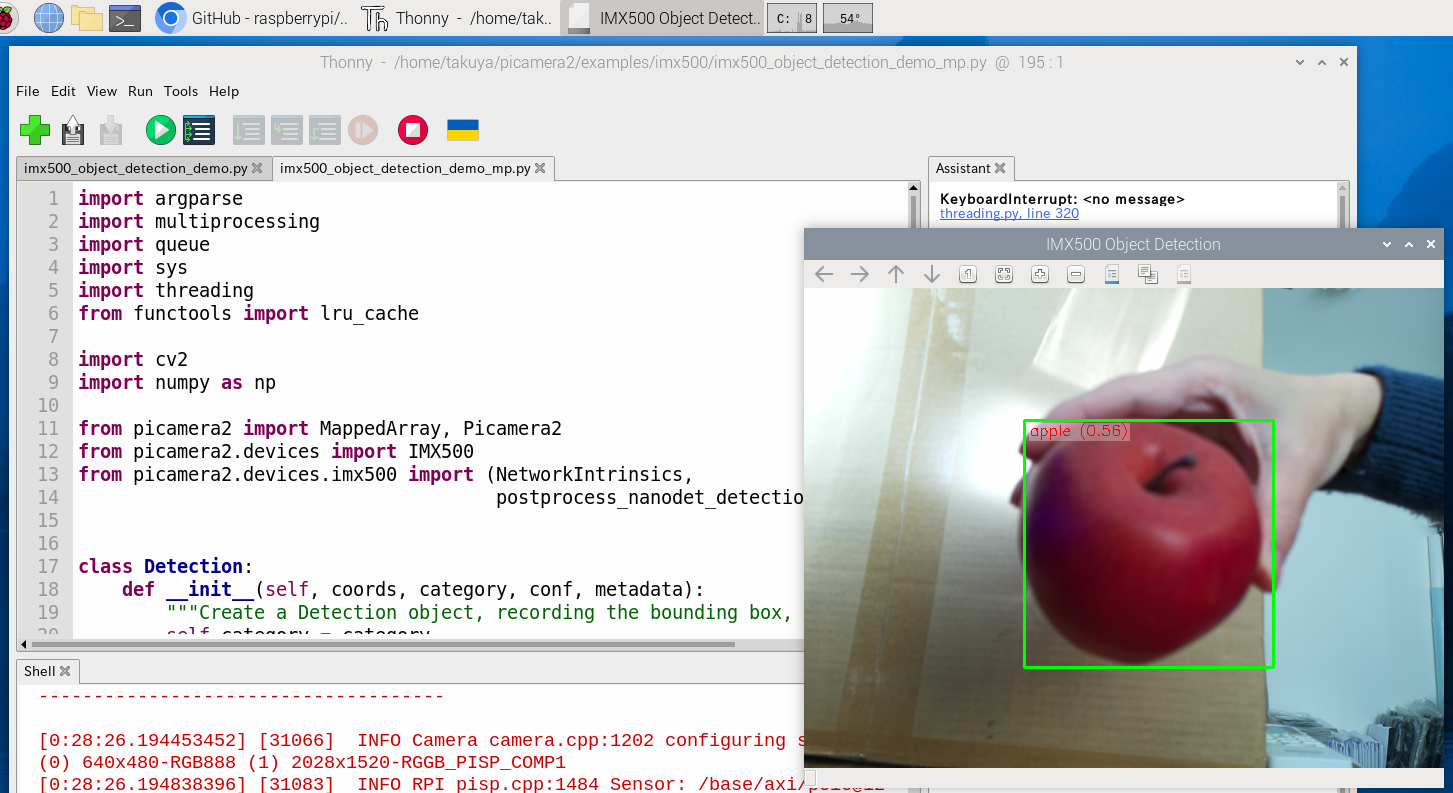

(動作中の様子)

当ブログの内容は、弊社製品の活用に関する参考情報として提供しております。

記載されている情報は、正確性や動作を保証するものではありません。皆さまの創意工夫やアイデアの一助となれば幸いです。